Big Data schreitet mit grossen Schritten in der Wirtschaft voran und ebnet den Weg für neue Formen der Datenanalyse. Auch Data Science gehört dazu: «Data Science ist ein Megatrend», sagt Christof Oberholzer, Business Area Manager Healthcare & Insurance bei bbv. «Firmen wagen sich vermehrt an entsprechende Projekte. Gleichzeitig erkennen wir aber auch, dass oftmals die Grundlagen fehlen, um Data Science tatsächlich erfolgreich im Unternehmen einzuführen und anzuwenden. Viele Firmen investieren bei Data Science zu wenig Zeit in die genaue Planung des Business-Cases.». Data-Science-Projekte müssen jedem Härtetest standhalten können – sei es aus wirtschaftlicher, technologischer oder auch ethischer Sicht, wenn etwa neue Erkenntnisse aus personenbezogenen Daten gewonnen werden. Daher muss auch bei Data Science eine klare Grenze zwischen ‘Research and Learning’ und produktivem Einsatz gezogen werden.

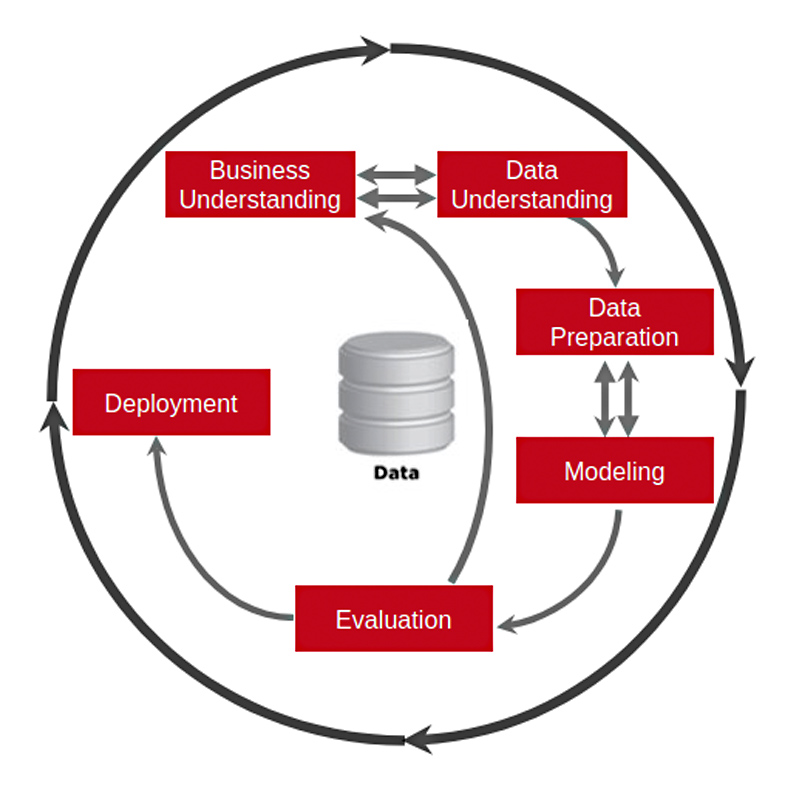

Welche Aufgaben müssen Unternehmen also meistern, damit das eigene Data-Science-Projekt zum Erfolg wird? Einen wichtigen Anhaltspunkt bietet der Cross Industry Standard Process for Data Mining, kurz CRISP DM. Er wurde bereits 1999 veröffentlicht, um Data-Mining-Prozesse branchenübergreifend zu standardisieren. Seither hat sich CRISP DM zum gängigsten Prozessmodell für Data-Mining-, Analyse- und Data-Science-Projekte entwickelt.

CRISP DM beschreibt 6 Phasen, die ein Data-Science-Lebenszyklus durchlaufen sollte. Diese Phasen dienen Unternehmen als Orientierung bei der Planung, Organisation und Implementierung von Data-Science-Projekten.

Der Data-Science-Lebenszyklus gemäss CRISP DM.

-

Geschäftsverständnis (Business Understanding)

Am Anfang eines Data-Science-Projekts steht das Geschäftsverständnis. Unternehmen evaluieren, welche Aufgaben und Prozesse durch Data Science optimiert werden können und legen die konkreten Ziele und Anforderungen sowie die grobe Vorgehensweise für das Projekt fest – inklusive benötigter Technologien und Tools. Ebenfalls muss das angestrebte Projekt auf Umsetzbarkeit und Wirtschaftlichkeit geprüft werden. «Oft suchen Unternehmen die eierlegende Wollmilchsau – den Data-Science-Case, der ohne weiteres Zutun ihr gesamtes Business optimiert», erklärt Francesco Spadafora, Software-Ingenieur bei bbv für Embedded Applications. «Wir empfehlen unseren Kunden, kleine Schritte zu gehen. Sie sollten nach den ‚Low-Hanging-Fruits’ greifen und in ihrem Business spezifische Punkte suchen, in denen Data Science tatsächlich Mehrwerte generiert.»

-

Datenverständnis (Data Understanding)

Anschliessend verschaffen sich Unternehmen einen Überblick über die Daten, die für den geplanten Anwendungsfall benötigt werden. Die vorhandenen Daten werden auf Verarbeitbarkeit, Inhalt und Qualität geprüft. Ziel ist es auch hier, aufgrund der vorhandenen Datenbasis die technische Machbarkeit des eigenen Projekts zu überprüfen. Die Schritte «Geschäftsverständnis» und «Datenverständnis» sind eng miteinander verzahnt: Es wird untersucht, ob die Daten punkto Umfang und Qualität für die zuvor formulierten Ziele ausreichen. Ist dies nicht der Fall, müssen die Ziele entweder angepasst oder geeignetere Datenquellen geschaffen werden.

-

Datenvorbereitung (Data Preparation)

In der Datenvorbereitung erstellt man die endgültigen Datensätze, die für die anschliessende Modellierung benötigt werden. Dazu gehört die Auswahl der zu verwendenden Datensätze, das Bereinigen oder Transformieren vorhandener Daten wie auch das Erstellen oder Hinzuziehen neuer Datensätze. «Die Datenvorbereitung macht in der Regel den Löwenanteil in einem Data-Sciene-Projekt aus», hält Oberholzer fest. «Vorhandene Daten zu büscheln ist das eine – sie brauchbar fürs Data-Science-Projekt zu machen das andere. Unter Umständen hat dies sogar prozessuale Änderungen im Betrieb zur Folge, um überhaupt die richtigen Daten gewinnen zu können.»

-

Datenmodellierung (Modeling)

Anhand von Testdatensätzen werden die für den Anwendungsfall wichtigsten Informationen aufgespürt. Dazu kommen etwa Algorithmen für Clusteranalysen, Klassifikationen, neuronale Netze, Entscheidungsbäume und auch klassische Statistik zum Einsatz. Diese Datenmodellierungsverfahren sind hochkomplex und oft kaum noch vollständig nachvollziehbar – weshalb oft die Black Box als Metapher hinzugezogen wird: «Man hat als Input die bekannten Datensätze und als Output die Auswertungen des Modells.. «Unternehmen ermitteln, mit welcher Modellierungstechnik sie die besten Resultate erzielen», erklärt Spadafora. Deshalb werden oftmals mehrere Modelle erstellt und bewertet, die auf verschiedenen Modellierungstechniken basieren. Der Datenwissenschaftler muss die Ergebnisse schliesslich auf Basis von Domänenwissen, den zuvor definierten Erfolgskriterien und dem Testdesign interpretieren.

-

Auswertung (Evaluation)

Nachdem verschiedene Modellierungstechniken ermittelt und getestet wurden, prüft man, welche davon die Aufgabenstellung am besten lösen kann. Eine genaue Auswertung der Ergebnisse und ein Abgleich mit den formulierten Projektzielen ist daher Pflicht. Ein klares Verständnis über die festgelegten Geschäftsziele ist deshalb zwingend erforderlich – weshalb sich eine enge Zusammenarbeit zwischen Data Scientists und Business-Stakeholdern anbietet. Nur so kann sichergestellt werden, dass tatsächlich Nutzen aus den erzielten Ergebnissen gezogen wird. Nach der Evaluation wird eine Liste sämtlicher Modelle erstellt, die sowohl die Ziele der Datenauswertung wie auch die Geschäftsziele erfüllt.

-

Bereitstellung (Deployment)

In der letzten Phase wird das trainierte oder erstellte Modell in die IT-Infrastruktur eingebettet, so dass es durchgehend in Betrieb ist. Dabei muss sowohl die Qualität der Daten wie auch die Performanz kontinuierlich überwacht und bei Bedarf optimiert werden.

Die Experten

Christof Oberholzer

Christof Oberholzer ist Business Area Manager Healthcare & Insurance bei bbv. Er hat über 25 Jahre Erfahrung in Software Engineering, Führung, Strategie, Kundenakquisition, Projektdurchführung und Beratung, Entwicklung von globalen und lokalen ERP-Produkten oder individuelle IT-Leistungen.

Francesco Spadafora

Francesco Spadafora war Software-Ingenieur bei bbv für Embedded Applications im Bereich Industrie und Medizintechnik. Während seines Studiums befasste er sich mit der Analyse von Daten aus Sensornetzwerken. Seither glaubt er, dass der nächste Schritt in der Innovation darin besteht, Systeme und Abläufe anhand der Erkenntnisse aus Daten besser zu verstehen.

Data Science Innovation Workshop

Mit unserem dreiteiligen Workshop können Sie die Potenziale und Risiken im Bereich Data Science schneller und besser einzuschätzen. Dabei unterstützen wir Sie ganz individuell mit unserer Prozess-, Methoden-, Technologie- und Business-Expertise. Gemeinsam entwickeln wir die vielversprechendsten Ideen zu einem belastbaren Business Case, so dass sie direkt realisierbar werden.